Je to snad už vlastnost od počátku lidstva porovnávat, kdo má co lepší. Tím spíše, že záleží na samotné metodice. Pokud je metodika správná, tak nám může napovědět, který ten počítač nebo jen procesor je lepší, výkonnější. A jednou z takových metodik je i Quantum Volume určená pro porovnání současných kvantových počítačů.

Ale ještě zůstaňme u klasických počítačů pro ucelení představy, jak se porovnávají výkony. Jedna věc je výkon jednotlivých součástí jako je procesor, grafická karta atd. Ale i v případě procesoru to může být nejednoznačné. Je například lepší mít více jader s nižší frekvencí? Nebo mít méně jader s více frekvencí? No, ale nikdy nepoužíváme procesor o samotě, vždy je to celý počítač, od procesoru, základní desky po grafickou kartu či RAM paměť. A na testování výkonů počítačů existuje spousta různých programů, tzv. benchmarků. Některé se tváří, že se snaží testovat počítač všeobecně, některé se přímo specializují na výkon při určitých činnostech, jako například při hraní her nebo renderování videí.

A člověk nebude daleko od pravdy, když si představí, že v případě benchmarků pro kvantové počítače to bude podobné.

A jedním z benchmarků je Quantum Volume (QV) s kterým přišlo IBM v roce 2017 a za své si jej vzalo i Honeywell. Ale nyní se pojďme podívat, co přesně vyjadřuje.

Obecně je QV definované jako metrika k měření výkonu, schopností a chybovosti kvantového počítače. Jedná se o jediné číslo, které by mělo v sobě zahrnout veškeré důležité aspekty.

Technické detaily Quantum Volume

Úplné detaily lze najít v článku „Validating quantum computers using randomized model circuits“. Základní myšlenkou je řada statistických testů (spuštění kvantových algoritmů), kdy se testují náhodné kvantové obvody stejné šířky (width – počet qubitů) a hloubky (depth – počet operací, tedy kvantových bran či hradel) a postupně hledáme největší náhodný kvantový obvod, který se úspěšně implementuje a provede.

Nyní se podíváme na zásadní faktory tohoto QV. Prvním jsou qubity. Z podstaty testu nezáleží na fyzikální realizaci qubitů, ale na jejich vlastnostech, i když většina vlastností vlastně záleží na fyzikální realizaci. Tady tedy záleží na jejich počtu, tedy jak široký (quantum circuit width) kvantový obvod můžeme vytvořit.

Důležitou vlastností je i doba koherence, tedy doba života qubitu. Je to doba, po kterou qubit drží vlastní kvantovou informaci. Po uplynutí koherenční doby pak tuto informaci můžeme ztratit. Z podstaty kvantové mechaniky se nejedná o přesný čas, ale o střední dobu života, kde k dekoherenci (ztrátě kvantové informace) dojde kolem oné střední doby.

Dalším důležitým parametrem z řady je chybovost. Každá kvantová operace má svoji chybovost, nebo míru důvěryhodnosti, tzv, fidelita. Dnešní procesory mají fidelitu typicky kolem 98%. Chyba jednotlivých operací se integruje. Tedy čím hlubší (quantum algorithm depth) algoritmus máme (tedy čím více operací na jeden qubit v řadě), tak větší chyba je. Je zde spojení i s dobou koherence, neboť více operací potřebuje více času, a tedy se nemusíme vejít do doby koherence.

A poslední velmi důležitou vlastností je propojení qubitů. Teoreticky v univerzálním kvantovém počítači by se měly moci kvantově provázat všechny qubity se všemi. A tady se výkon mezi jednotlivými fyzikálními realizacemi hodně liší. Například u qubitů z uvězněných iontů je poměrně jednoduché provázat mezi sebou libovolné qubity. Na druhou stranu u supravodivých můžeme kvantově provázat jen ty, které jsou u sebe blízko. To znamená, pokud chceme provázat dva qubity daleko od sebe, tak je musíme proházet (tzv. operace SWAP) aby se k sobě dostali blíže. To znamená spoustu operací navíc, a tedy větší vlastní hloubka kvantového obvodu.

Z této poslední vlastnosti plyne, že kvantový počítač od D-Wave není univerzální kvantový počítač, protože propojení qubitů je omezené. Z tohoto důvodu ani nemá smysl QV testovat, neboť bychom dostali stejně velmi malé skóre.

Větší technické detaily

Konkrétně, základní vzoreček pro výpočet QV je

![]()

kde ![]() počet použitých qubitů,

počet použitých qubitů, ![]() je maximální počet qubitů dostupných na testovacím zařízení,

je maximální počet qubitů dostupných na testovacím zařízení, ![]() je efektivní dosažitelné hloubka kvantového obvodu a

je efektivní dosažitelné hloubka kvantového obvodu a ![]() je efektivní chybovost kvantových operací mezi různými dvěma qubity.

je efektivní chybovost kvantových operací mezi různými dvěma qubity.

Co tedy z Quantum Volume plyne

Obecně lze říci, čím větší číslo, tím komplexnější problémy kvantový počítač může řešit. Nyní si přidejme pár postřehů a důsledků QV:

- Jak jsme zmínili výše, QV nemá do D-Wave kvantové annealery smysl, skóre by bylo velmi malé

- V současné době neperfektních qubitů, supravodivé qubity většinou budou mít horší výsledek než například uvězněné ionty, kvůli náročnějšímu propojení libovolných qubitů

- Ze vzorce výpočtu QV plyne, že na stroji s

qubity je maximální skóre

qubity je maximální skóre

- QV je navrženo pro současné kvantové procesory do

qubitů

qubitů - Hodně záleží i na kompilaci. Kompilátor vezme váš kód a co nejlépe ho optimalizuje pro dané zařízení tak aby minimalizoval počet operací, ale i aby dal co nejblíže qubity, které by se měly v průběhu algoritmu provázat. Proto také na stejném procesoru můžete zvýšit QV i jen díky lepší optimalizaci a kompilaci, tak jak to například udělal Honeywell z hodnoty 64 na 128

Pár příkladů k zamyšlení o výkonu současných kvantových počítačů.

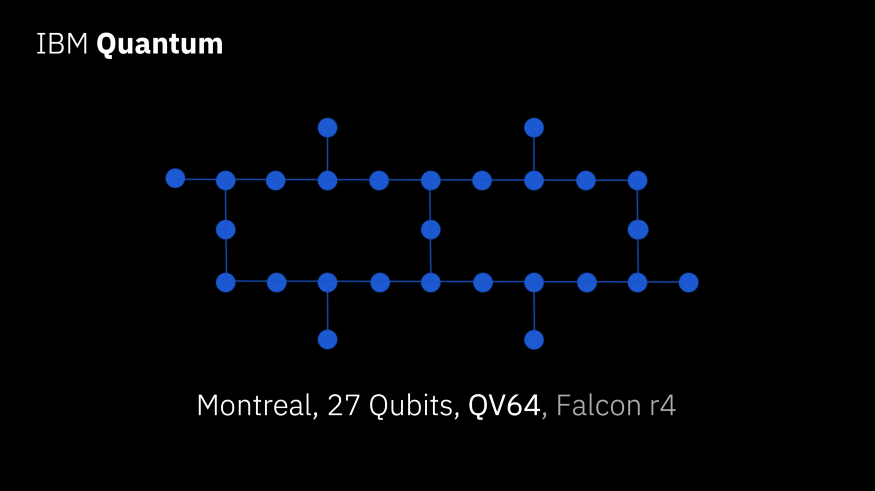

Například kvantový procesor Montreal od IBM má 27 qubitů. Tedy teoretická hodnota QV je přes 67 milionů. Ale IBM naměřilo jen 64, tedy ![]() . To značí, že je tam velká chybovost, nebo spíše, při pohledu na diagram v úvodu, lze odhadnout, že většina ztráty bude pocházet z provázání různých qubitů, zvláště negativně přispívat budou qubity daleko od sebe, a tedy s velkým množstvím SWAP operací. V kompilaci s krátkou koherenční dobou, chybovostí a množství kvantových operací se pak dosáhne mnohem nižšího výsledku, než je ten teoretický.

. To značí, že je tam velká chybovost, nebo spíše, při pohledu na diagram v úvodu, lze odhadnout, že většina ztráty bude pocházet z provázání různých qubitů, zvláště negativně přispívat budou qubity daleko od sebe, a tedy s velkým množstvím SWAP operací. V kompilaci s krátkou koherenční dobou, chybovostí a množství kvantových operací se pak dosáhne mnohem nižšího výsledku, než je ten teoretický.

Dále například Google se svým procesorem Sycamore s 53 qubity by teoreticky mohl dosáhnout obrovské hodnoty. Avšak žádná hodnota QV není publikovaná (procesor ani není veřejně dostupný, aby nějaká třetí osoba test provedla). Můžeme se jen dohadovat, že skóre je asi velmi malé. Problém bude podobný jako u výše zmíněného čipu Montreal. Pokud máme 53 qubitů a daleko od sebe, tedy s ještě větším množstvím SWAP operací, a tedy hloubkou, pak takový test může jednoduše dávat hodně malé hodnoty. Ale také to říká, že procesor ještě není připravený na komplexní výpočty, který by využil potenciálu všech qubitů.

Závěr

Quantum Volume je rozumná metrika pro benchmarking současných tzv. NISQ (menší kvantové počítače s vyšší chybovostí), která zahrnuje nejen základní vlastnosti jako je počet qubitů, chybovost kvantových operací či propojení qubitů, ale testuje systém jako komplex, tedy i elektroniku, kompilaci, atd. QV je navíc nezávislý na fyzikální realizaci a lze jej spustit na libovolný kvantový počítač.

Je to slušný nástroj na porovnání současných kvantových počítačů, kdy počet qubitů je většinou menší než potřebná hloubka nutná pro výpočet. Ale již není vhodný do budoucna, kde budeme mít tisíce a více qubitů, neboť ne nutně pro praktické počítání budeme potřebovat i hloubku kvantového obvodu tisíc a více operací. To by již byl velice extrémní algoritmus.

Více informací můžete najít na:

- Originální článek popisující QV – https://arxiv.org/pdf/1811.12926.pdf

- Vlastní měření pomocí Qiskit knihovny – https://qiskit.org/textbook/ch-quantum-hardware/measuring-quantum-volume.html